Newlle 作为 GNOME 桌面的虚拟 AI 助手,集成了 Google Gemini、OpenAI、Groq 的 API,并支持本地 LLMs,现已发布新版本。Newlle 一直在稳步扩展其 AI 集成和功能,随着 Newelle 1.2 版本的推出,为那些希望在 GNOME 桌面上使用 AI 的用户带来了更多功能。

Newelle 1.2 版本引入了 Llama.cpp 集成,并支持从 CPU 到设备特定 GPU 后端的多种后端使用,以及值得注意的 Vulkan 支持。此外,还引入了新的模型库,用于 ollama 和 llama.cpp 的使用。

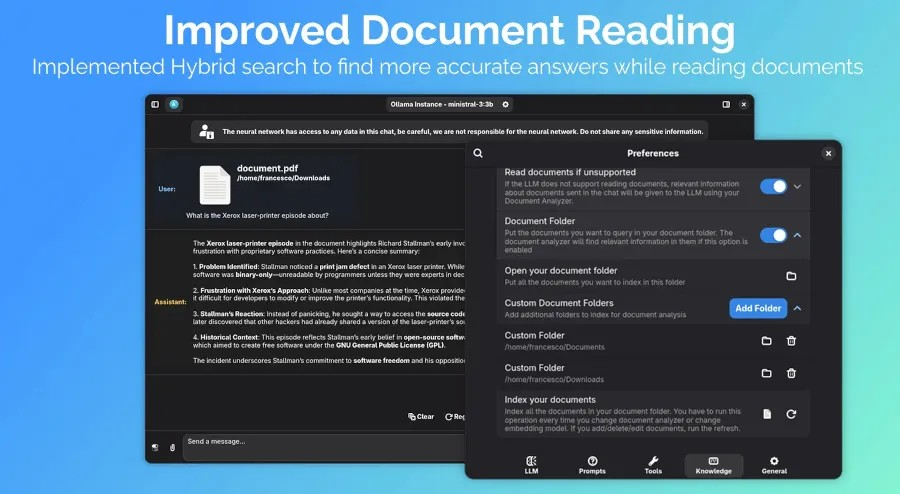

对于希望在文件系统中与文档进行 AI 集成的用户,现在有一个新的混合搜索功能,可以更好地处理文档阅读。

同样可能引起争议的是,为那些信任 AI 在本地系统上运行命令的用户提供的新命令执行工具。

其他工作包括引入工具组、改进 MCP 服务器处理、语义内存处理器、聊天导入/导出以及其他功能。

有关 GNOME 的此更新可选 AI 助手的更多详细信息,可通过 This Week in GNOME 找到。Newelle 1.2 可以从 Flathub 下载。

转自 GNOME’s AI Assistant Newelle Adds Llama.cpp Support, Command Execution Tool – Phoronix

Linuxeden开源社区

Linuxeden开源社区